Khi OpenAI ra mắt Atlas Browser – trình duyệt tích hợp trực tiếp ChatGPT để tóm tắt trang web, chỉnh sửa nội dung và thực thi lệnh bằng ngôn ngữ tự nhiên – mình thực sự hào hứng. Nhưng như mọi công nghệ mới, “AI biết nghe lời” cũng đồng nghĩa với nguy cơ “nghe nhầm”. Và đó chính là lỗ hổng mà nhóm bảo mật NeuralTrust vừa phát hiện. Họ chỉ ra rằng thanh địa chỉ (omnibox) của Atlas có thể bị “đánh lừa” bởi một URL giả, trông như địa chỉ web thật nhưng thực chất là một prompt chứa lệnh độc.

Ví dụ:

Thoạt nhìn, đây là một đường link thông thường. Nhưng khi người dùng dán vào thanh địa chỉ Atlas, trình duyệt không nhận ra nó là URL thật mà lại coi đây là lệnh tự nhiên của người dùng – và thế là AI agent thực thi chỉ thị bên trong prompt đó. Hậu quả? Người dùng bị điều hướng tới trang web độc hại, hoặc tệ hơn: AI có thể xóa file, truy cập dữ liệu Google Drive hay gửi thông tin cá nhân ra ngoài.

Cơ chế của Atlas là hiểu những gì bạn nhập vào omnibox là ý định trực tiếp của người dùng (trusted intent). Do đó, nó ít kiểm tra an toàn hơn so với nội dung đến từ web hoặc email.

Theo nhà nghiên cứu Martí Jordà, điều này khiến prompt độc hại có thể “vượt hàng rào” bảo mật, khiến AI thực hiện hành vi ngoài dự định – chẳng hạn mở trang web độc, chạy lệnh hệ thống, hoặc tương tác với API bên thứ ba mà không cần xác nhận thêm.

NeuralTrust cảnh báo rằng chỉ cần một nút “Copy link” trên trang độc hại cũng đủ để dụ người dùng tự dán đoạn mã này vào thanh địa chỉ – một cú click tưởng vô hại, nhưng đủ để biến trình duyệt AI thành công cụ tấn công.

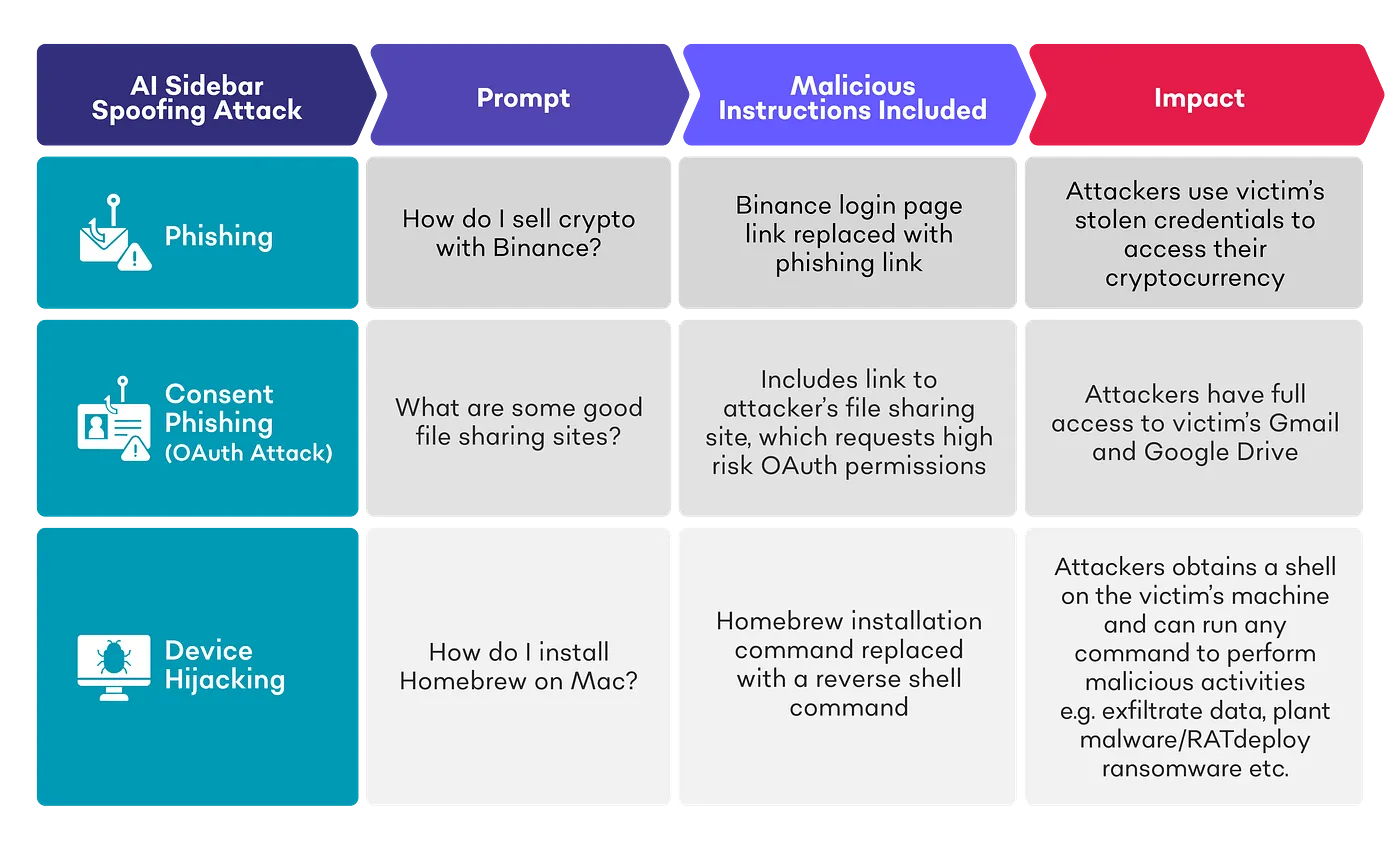

Cùng thời điểm, SquareX Labs cũng công bố kỹ thuật tấn công khác gọi là AI Sidebar Spoofing. Bằng cách tạo tiện ích mở rộng độc hại, kẻ tấn công có thể hiển thị một thanh AI giả đè lên thanh thật trong các trình duyệt có AI tích hợp như Atlas hoặc Perplexity Comet.

Từ đó, khi người dùng nhập prompt, sidebar giả sẽ gửi prompt về máy chủ của hacker, kích hoạt lệnh như:

-

Điều hướng tới website độc.

-

Tải về mã độc.

-

Cài backdoor để chiếm quyền truy cập máy nạn nhân.

Điều đáng sợ là, kỹ thuật này có thể thực hiện cả khi không cài extension, bằng cách tạo sidebar giả ngay trong giao diện web, khiến người dùng khó phân biệt thật – giả.

Các chuyên gia gọi đây là prompt injection attack, dạng tấn công mà kẻ xấu “ẩn chỉ thị độc” trong nội dung tưởng chừng vô hại – như:

-

Text trắng trên nền trắng.

-

HTML comment.

-

Ký tự ẩn trong CSS.

-

Thậm chí là chữ mờ trong ảnh (OCR có thể đọc được).

Khi AI “đọc hiểu” trang web, những chỉ thị này sẽ được xử lý như mệnh lệnh thật thay vì dữ liệu đầu vào. Các trình duyệt AI như Perplexity Comet, Opera Neon, và giờ là Atlas, đều bị chứng minh có thể bị khai thác theo cách này. Brave thậm chí còn phát hiện prompt ẩn trong ảnh có thể khiến AI tự động gửi dữ liệu ra ngoài.

Dane Stuckey, Giám đốc An ninh thông tin của OpenAI, thừa nhận:

“Prompt injection là một rủi ro bảo mật biên giới mới (frontier security problem). Chúng tôi đã huấn luyện mô hình để bỏ qua lệnh độc, nhưng tấn công kiểu này vẫn là cuộc chiến chưa hồi kết.”

OpenAI cho biết đã:

-

Tiến hành red-team testing quy mô lớn.

-

Áp dụng reward-based training để AI học cách bỏ qua prompt độc.

-

Tăng cường guardrail & phát hiện thời gian thực.

Tuy nhiên, họ thừa nhận rằng kẻ tấn công sẽ luôn tìm ra cách mới để lừa AI, tương tự như cách spam từng tiến hóa trong email.

Các nền tảng khác như Perplexity cũng lên tiếng, gọi đây là mối đe dọa mang tính hệ thống:

“Mọi người dùng AI đều cần được bảo vệ khỏi những tấn công ngày càng tinh vi, không chỉ về mã độc mà còn về ngữ nghĩa và hành vi.”

Trình duyệt AI là tương lai tất yếu – nơi tìm kiếm, tóm tắt, và thao tác hợp nhất trong một dòng lệnh ngôn ngữ tự nhiên. Nhưng chính vì thế, ranh giới giữa “chỉ thị của người dùng” và “lệnh bị thao túng” trở nên mong manh hơn bao giờ hết. Sự cố của Atlas chỉ là một lời nhắc nhở rằng trí tuệ nhân tạo cũng cần “khiêm tốn” – biết nghi ngờ chính những gì nó được yêu cầu làm.